Onderzoekers van The AI Institute combineren diverse vision foundation modellen om robotleren te verbeteren.

Op het gebied van robotica zijn op vision gebaseerde leersystemen een veelbelovende strategie om machines hun omgeving te laten interpreteren en ermee te interacteren. Om effectief robotleren te vergemakkelijken, moeten deze systemen robuuste representaties van de wereld bieden, waardoor robots hun omgeving kunnen begrijpen en erop kunnen reageren.

Traditionele benaderingen richten zich doorgaans op modellen met één taak, zoals classificatie, segmentatie of objectdetectie. Afzonderlijk omvatten deze niet het diverse begrip van een scène dat vereist is voor robotleren. Deze tekortkoming onderstreept de behoefte aan een meer holistische oplossing die in staat is een breed spectrum aan visuele signalen efficiënt te interpreteren. Onderzoekers van The AI Institute in Cambridge (Massachusetts) ontwikkelden Theia om deze kloof te dichten.

Goede resultaten

Theia is een model dat is ontworpen om de expertise van meerdere kant-en-klare Vision Foundation Models (VFM's) te distilleren tot één model. Het combineert de sterke punten van meerdere verschillende modellen, die elk zijn getraind voor een specifieke visuele taak. Theia genereert hieruit een rijkere, uniforme visuele representatie die kan worden gebruikt om de leerprestaties van robots te verbeteren.

Robotstrategieën die zijn getraind met behulp van de encoder van Theia behaalden een hoger gemiddeld taaksuccespercentage van 80,97% bij evaluatie tegen twaalf robotsimulatietaken, een statistisch significante verbetering ten opzichte van andere representatiekeuzes. In experimenten met echte robots gebruikten de onderzoekers het klonen van gedrag om robotstrategie te leren over vier taken met meerdere stappen. Het getrainde succespercentage met behulp van Theia was gemiddeld 15% hoger dan een strategie getraind met behulp van de op één na beste representatie.

Het ontwerp

Het ontwerp van Theia is gebaseerd op een distillatieproces dat de sterke punten van meerdere VFM's integreert, zoals CLIP (vision language), DINOv2 (dense visual correlation) en ViT (classification), en nog veel meer. Door deze modellen zorgvuldig te selecteren en te combineren, kan Theia robuuste visuele representaties produceren die de downstream robotleerprestaties kunnen verbeteren.

In de kern bestaat Theia uit een visuele encoder (backbone) en een set feature translators, die samenwerken om de kennis van meerdere VFM's in een uniform model op te nemen. De visuele encoder genereert latente representaties die uiteenlopende visuele inzichten vastleggen. Deze representaties worden vervolgens verwerkt door de feature translators, die ze verfijnen door de outputkenmerken te vergelijken met de basiswaarheid.

Deze vergelijking dient als een toezichthoudend signaal, dat de latente representaties van Theia optimaliseert om hun diversiteit en nauwkeurigheid te verbeteren. Deze geoptimaliseerde latente representaties worden vervolgens gebruikt om beleidsleermodellen te verfijnen, waardoor robots een breed scala aan taken met grotere nauwkeurigheid kunnen uitvoeren.

Leren in het lab

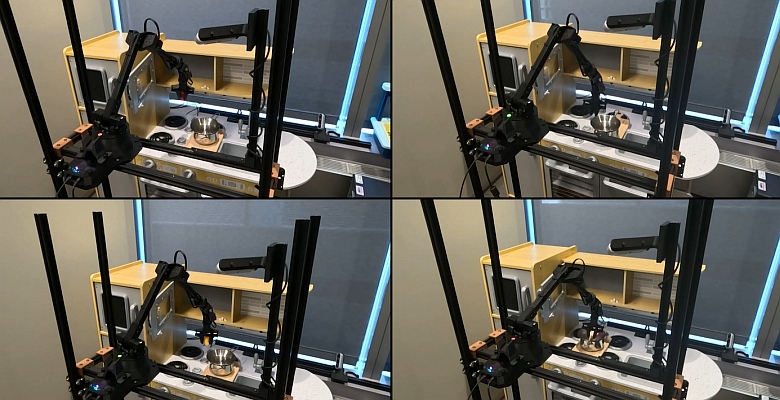

Onderzoekers van het instituut testten Theia in simulatie en op een aantal robotplatforms, waaronder Spot en een WidowX-robotarm. Voor een van de rondes van laboratoriumtesten gebruikten ze Theia om een strategie te trainen waarmee een robot een kleine magnetron kon openen, namaaketen erin kon plaatsen en de magnetrondeur kon sluiten.

Hoewel het voor een persoon eenvoudig klinkt, is de magnetrontaak een complexer gedrag omdat het succesvolle voltooiing van meerdere stappen vereist: het oppakken van het object, het plaatsen ervan in de magnetron en het sluiten van de magnetrondeur. De strategie die is getraind met Theia behoort tot de best presterende voor elk van deze stappen, vergelijkbaar met E-Radio, een andere aanpak die ook meerdere VFM's combineert, hoewel niet specifiek voor roboticatoepassingen.

Encoder

Voorheen moesten onderzoekers alle VFM's combineren, wat traag en rekenintensief is. Of ze moesten selecteren welke VFM ze gebruikten om de scène voor de robot weer te geven. Dat is bijvoorbeeld een segmentatieafbeelding van een segmentatiemodel, een diepteafbeelding van een dieptemodel of een tekstklassenaam van een beeldclassificatiemodel, die elk verschillende typen en granulariteit van informatie over de scène bieden. Over het algemeen kan één VFM goed werken voor één taak met bekende objecten, maar is het misschien niet de juiste keuze voor andere taken of andere robots.

Met Theia kan dezelfde afbeelding van de robot door de encoder worden gevoerd om één enkele weergave met alle belangrijke informatie te genereren. Die representatie kan vervolgens worden ingevoerd in Theia's segmentatiedecoder om een segmentatiebeeld uit te voeren. Dezelfde representatie kan worden ingevoerd in Theia's dieptedecoder om een dieptebeeld uit te voeren, enzovoort.

Elke decoder gebruikt dezelfde representatie als invoer omdat de gedeelde representatie de informatie bevat die nodig is om alle uitvoer van de originele VFM's te genereren. Hierdoor wordt het trainingsproces gestroomlijnd en worden acties overdraagbaar naar een breder scala aan situaties.

Prioriteit

Een van de belangrijkste voordelen van Theia ten opzichte van andere VFM's is de efficiëntie. Het trainen van Theia vereist ongeveer 150 GPU-uren op datasets zoals ImageNet, waardoor de benodigde rekenkracht wordt verminderd in vergelijking met andere modellen. Deze hoge efficiëntie gaat niet ten koste van de prestaties, waardoor Theia een praktische keuze is voor zowel onderzoek als toepassing. Met een kleinere modelgrootte en verminderde behoefte aan trainingsgegevens, bespaart Theia rekenkracht tijdens zowel de trainings- als de fine-tuningprocessen.

Met Theia kunnen robots sneller en effectiever leren en zich aanpassen. Ze verfijnen kennis uit meerdere visiemodellen tot compacte representaties voor classificatie, segmentatie, dieptevoorspelling en andere modaliteiten. Hoewel er nog veel werk moet worden verzet voordat een succespercentage van 100% wordt bereikt bij complexe roboticataken met Theia (of andere VFM's), is het model een stap voorwaarts op weg naar het doel: met minder trainingsdata en minder computerbronnen.

Foto: The AI Institute