Onderzoekers van MIT CSAIL gebruiken door AI gegenereerde afbeeldingen om een robothond te trainen in parkour, zonder echte data.

Voor robotici is er één uitdaging die boven alle andere uitsteekt: generalisatie, de mogelijkheid om machines te creëren die zich kunnen aanpassen aan elke omgeving of omstandigheid. Sinds de jaren zeventig is het vakgebied geëvolueerd van het schrijven van geavanceerde programma's naar het gebruik van deep learning, waarbij robots worden geleerd om direct te leren van menselijk gedrag. Maar er blijft een kritiek knelpunt: datakwaliteit.

Om te verbeteren, moeten robots scenario's tegenkomen die de grenzen van hun mogelijkheden verleggen. Dit proces vereist traditioneel menselijk toezicht, waarbij operators robots voorzichtig uitdagen om hun mogelijkheden uit te breiden. Naarmate robots geavanceerder worden, stuit deze praktische aanpak op een schaalprobleem. De vraag naar trainingsdata van hoge kwaliteit overtreft het vermogen van mensen om deze te leveren.

Simulatie plus AI

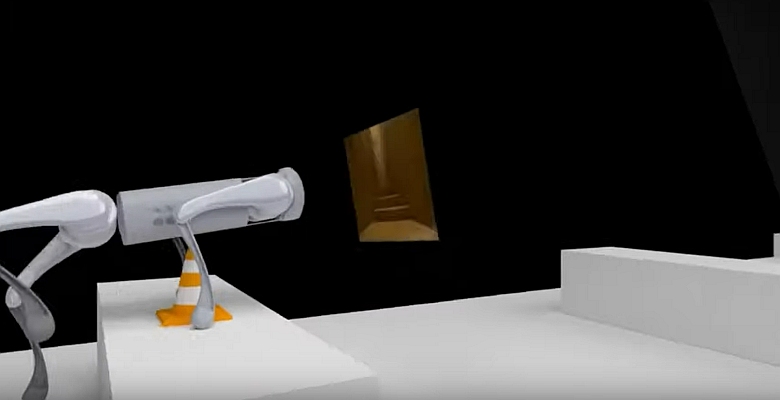

Een team onderzoekers van het MIT Computer Science and Artificial Intelligence Laboratory (CSAIL) in Cambridge (Massachusetts)heeft een nieuwe aanpak ontwikkeld voor robottraining. Deze zou de inzet van aanpasbare, intelligente machines in echte omgevingen aanzienlijk kunnen versnellen. Het nieuwe systeem, genaamd LucidSim, maakt gebruik van recente ontwikkelingen in generatieve AI en fysicasimulatoren om diverse en realistische virtuele trainingsomgevingen te creëren. Hiermee kunnen robots volgens de onderzoekers prestaties op expertniveau bereiken in moeilijke taken zonder echte data.

LucidSim combineert fysicasimulatie met generatieve AI-modellen 0. Het pakt daarmee een van de meest hardnekkige uitdagingen in robotica aan: het overbrengen van vaardigheden die in simulatie zijn geleerd naar de echte wereld. De 'sim-to-real gap' — de ongelijkheid tussen gesimuleerde trainingsomgevingen en de complexe, onvoorspelbare echte wereld – is al lang een fundamentele uitdaging bij het trainen van robots. Eerdere benaderingen vertrouwden vaak op dieptesensoren, die het probleem vereenvoudigden, maar cruciale complexiteiten in de echte wereld misten.

In de kern gebruikt LucidSim grote taalmodellen om verschillende gestructureerde beschrijvingen van omgevingen te genereren. De beschrijvingen worden met behulp van generatieve modellen vervolgens omgezet in afbeeldingen. Om ervoor te zorgen dat deze afbeeldingen de natuurkunde uit de echte wereld weerspiegelen, wordt een onderliggende natuurkundesimulator gebruikt om het generatieproces te begeleiden.

ChatGPT

De onderzoekers wilden robots met zicht leren hoe ze hun prestaties konden verbeteren met behulp van menselijke feedback. Maar toen realiseerden ze zich dat geen puur op zicht gebaseerd beleid hadden. Om data te verzinnen, genereerde het team realistische afbeeldingen door dieptekaarten te extraheren (die geometrische informatie verschaffen) en semantische maskers (die verschillende delen uit de gesimuleerde scène van een afbeelding labelen). Maar met een strakke controle over de compositie van de afbeeldinginhoud, zou het model vergelijkbare afbeeldingen produceren die niet van elkaar verschilden met dezelfde prompt. Dus bedachten ze een manier om verschillende tekstprompts te verkrijgen van ChatGPT.

Deze aanpak resulteerde echter slechts in één afbeelding. Om korte, samenhangende video's te maken die dienen als kleine 'ervaringen' voor de robot, sleutelden de wetenschappers wat beeldmagie in elkaar tot een andere nieuwe techniek die het team creëerde, genaamd 'Dreams In Motion. Het systeem berekent de bewegingen van elke pixel tussen frames, om één gegenereerde afbeelding te vervormen tot een korte video met meerdere frames. Dreams In Motion doet dit door rekening te houden met de 3D-geometrie van de scène en de relatieve veranderingen in het perspectief van de robot.

Prestaties

Volgens de onderzoekers presteert hun oplossing presteren beter dan domeinrandomisatie, een methode die in 2017 is ontwikkeld. Deze past willekeurige kleuren en patronen toe op objecten in de omgeving, wat tegenwoordig nog steeds als de meest gebruikte methode wordt beschouwd. Deze techniek genereert diverse gegevens, maar het ontbreekt aan realisme. LucidSim pakt zowel diversiteits- als realismeproblemen aan. Zelfs zonder de echte wereld te zien tijdens de training kan de robot obstakels in echte omgevingen herkennen en erdoorheen navigeren.

Het team is vooral enthousiast over de mogelijkheden om LucidSim toe te passen op domeinen buiten viervoetige voortbeweging en parkour, hun belangrijkste testbed. Een voorbeeld is mobiele manipulatie, waarbij een mobiele robot de taak krijgt om objecten in een open ruimte te hanteren. Ook kleurwaarneming is cruciaal.

Vandaag de dag leren robots nog steeds van echte demonstraties. Het verzamelen van data tijdens demonstraties is eenvoudig. Maar het opschalen van een echte robot-teleoperatie-opstelling naar duizenden vaardigheden is een uitdaging, omdat een mens elke scène fysiek moet opzetten. De onderzoekers hopen dit gemakkelijker te maken, en dus kwalitatief schaalbaarder, door gegevensverzameling naar een virtuele omgeving te verplaatsen.

De echte expert

Het team testte LucidSim met een alternatief, waarbij een deskundige leraar de vaardigheid demonstreert waar de robot van kan leren. De resultaten waren verrassend: robots die door de expert waren getraind, hadden moeite en slaagden slechts in 15% van de gevallen. Zelfs het verviervoudigen van de hoeveelheid trainingsdata van experts bracht nauwelijks verandering. Maar toen robots hun eigen trainingsdata verzamelden via LucidSim, veranderde het verhaal drastisch. Alleen al door de datasetgrootte te verdubbelen, steeg het succespercentage naar 88%. Door de robot meer data te geven, verbetert de prestatie ervan op een monotone manier. Uiteindelijk wordt de student de expert.

Het LucidSim-framework biedt een oplossing door generatieve modellen te gebruiken om diverse, realistische visuele data te creëren voor elke simulatie. Dit werk zou de inzet van robots die zijn getraind in virtuele omgevingen voor taken in de echte wereld aanzienlijk kunnen versnellen. LucidSim baant de weg naar een nieuwe generatie intelligente, aanpasbare machines: robot die leren navigeren in onze complexe wereld zonder er ooit een robotvoet in te zetten.

De wetenschappelijke publicatie vindt u hier.

Foto: screenshot video MIT CSAIL