Het uitvoeren van mensachtige bewegingen is voor robots een notoire uitdaging. Maar er worden vorderingen gemaakt.

Lopen en rennen brengt inherente biologische redundanties met zich mee waardoor we ons kunnen aanpassen aan de omgeving of onze loop-/rensnelheid te veranderen. Gezien de complexiteit hiervan is het reproduceren van deze mensachtige bewegingen in robots een notoire uitdaging. De huidige modellen hebben vaak moeite om tegemoet te komen aan onbekende of uitdagende omgevingen, waardoor ze minder efficiënt en effectief zijn. Dit komt omdat AI geschikt is voor het genereren van één of een klein aantal correcte oplossingen.

Deep reinforcement learning

Bij levende organismen en hun beweging is er niet slechts één correct patroon dat gevolgd moet worden. Er is een hele reeks mogelijke bewegingen, en het is niet altijd duidelijk welke de beste of meest efficiënte is. Een internationale groep onderzoekers heeft een nieuwe benadering ontwikkeld voor het imiteren van menselijke bewegingen. De groep bestond uit medewerkers van de Tohoku University in Sendai (350 km noordelijk van Tokyo) en de École Polytechnique Fédérale de Lausanne.

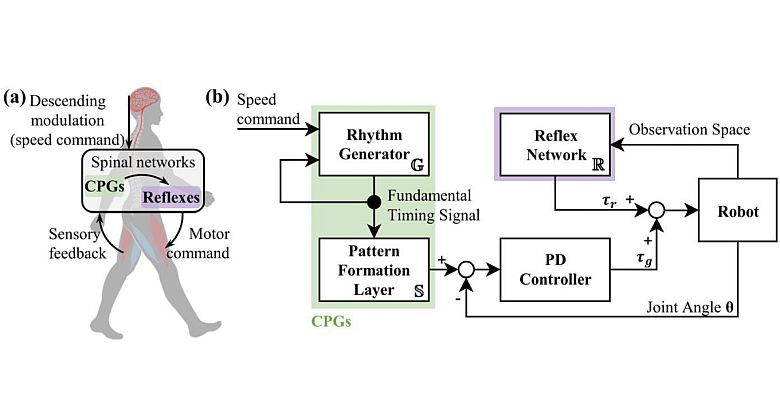

De wetenschappers combineren centrale patroongeneratoren (CPG's) en deep reinforcement learning (DRL). De methode imiteert niet alleen loop- en loopbewegingen, maar genereert ook bewegingen voor frequenties waar bewegingsgegevens ontbreken. Ook maakt de methode vloeiende overgangsbewegingen van lopen naar rennen en aanpassing aan omgevingen met onstabiele oppervlakken mogelijk.

Deep reinforcement learning breidt het traditionele versterkende leren uit door gebruik te maken van diepe neurale netwerken om complexere taken uit te voeren Dit maakt rechtstreeks leren van ruwe sensorische input mogelijk, waardoor flexibelere en krachtigere leermogelijkheden mogelijk worden. Het nadeel zijn de hoge rekenkosten die gepaard gaan met het verkennen van een grote hoeveelheid data, vooral wanneer het systeem een hoge mate van vrijheid heeft.

AI-CPG

Een andere benadering is imitation learning (IL), waarbij een robot leert door bewegingsmeetgegevens te imiteren van een mens die dezelfde bewegingstaak uitvoert. IL is goed in het leren in stabiele omgevingen, maar heeft het moeite wanneer het wordt geconfronteerd met nieuwe situaties of omgevingen die het tijdens de training niet is tegengekomen. Het vermogen om effectief aan te passen en te navigeren wordt beperkt door de beperkte reikwijdte van de aangeleerde gedragingen.

De onderzoekers hebben veel beperkingen van deze twee benaderingen overwonnen door ze te combineren. IL werd gebruikt om een CPG-achtige controller te trainen. In plaats van deep learning op de centrale patroongeneratoren toe te passen, pasten ze het toe op een vorm van een reflex-neuraal netwerk dat de CPG's ondersteunde. De patroongeneratoren zijn neurale circuits die, net als een biologische geleider, ritmische patronen van spieractiviteit genereren. Bij dieren werkt een reflexcircuit samen met CPG's om adequate feedback te geven waarmee ze hun snelheid en loop-/renbewegingen kunnen aanpassen aan het terrein.

Door de structuur van CPG en zijn reflexieve tegenhanger over te nemen, bereikt de adaptieve geïmiteerde CPG (AI-CPG) -methode een opmerkelijk aanpassingsvermogen en stabiliteit bij het genereren van bewegingen, terwijl menselijke bewegingen worden nagebootst. Deze doorbraak biedt nieuwe mogelijkheden voor het genereren van mensachtige bewegingen in robotica, met een ongekend aanpassingsvermogen aan de omgeving. De nieuwe methode vertegenwoordigt een belangrijke stap voorwaarts in de ontwikkeling van generatieve AI-technologieën voor robotbesturing, met potentiële toepassingen in verschillende industrieën.

De wetenschappelijke publicatie vindt u hier.

Ill.: Tohoku University