Een robot met menselijke gezichtsuitdrukkingen kan een revolutie in de omgang met robots betekenen.

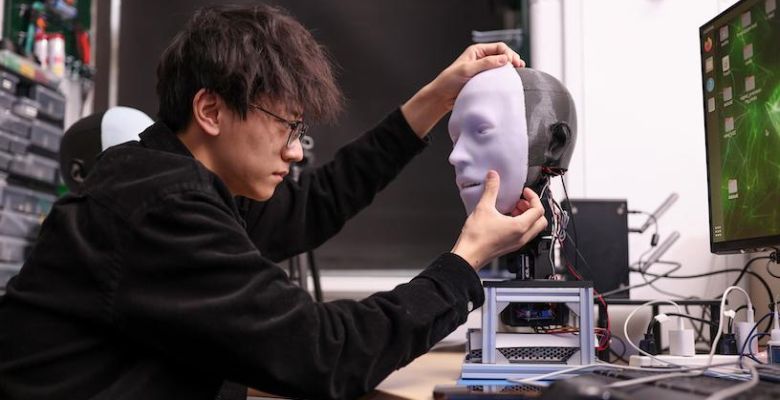

Ingenieurs van Columbia University in the City of New York bouwden Emo, een met silicium bekleed robotgezicht dat oogcontact maakt. Het gezicht gebruikt twee AI-modellen om de glimlach van een persoon te anticiperen en na te bootsen voordat de persoon daadwerkelijk lacht. De ontwikkelaars spreken van een grote vooruitgang in robots die menselijke gezichtsuitdrukkingen nauwkeurig voorspellen, interacties verbeteren en vertrouwen tussen mens en robot.

Communicatie

Wat zou u doen als u naar een robot met een mensachtig hoofd liep en deze eerst naar u zou glimlachen? U zou waarschijnlijk teruglachen en misschien het gevoel hebben dat er echt contact is. Maar hoe weet een robot hoe hij dit moet doen? Of een betere vraag: hoe krijgt hij het voor elkaar dat u teruglacht?

Mensen raken aan robots die bedreven zijn in verbale communicatie, mede dankzij de vooruitgang in grote taalmodellen zoals ChatGPT. Maar de non-verbale communicatievaardigheden van robots, vooral gezichtsuitdrukkingen, zijn ver achtergebleven. Het ontwerpen van een robot die niet alleen een breed scala aan gezichtsuitdrukkingen kan maken, maar ook weet wanneer hij deze moet gebruiken, is een hele klus.

Engineers aan Columbia Engineering werken al ruim vijf jaar aan deze uitdaging. In een nieuwe studie onthult de groep Emo, een robot die anticipeert op gezichtsuitdrukkingen en deze gelijktijdig met een mens uitvoert. Het 'gezicht' heeft zelfs geleerd een aankomende glimlach te voorspellen ongeveer 840 ms voordat de persoon lacht. Daarom kan het de glimlach tegelijkertijd met de persoon uitdrukken.

Twee uitdagingen

Het onderzoeksteam stond voor twee uitdagingen:

- hoe mechanisch een expressief veelzijdig robotgezicht te ontwerpen dat complexe hardware en bedieningsmechanismen omvat;

- weten welke expressie moet worden gegenereerd, zodat ze natuurlijk, actueel en echt lijken.

Het team stelde voor om een robot te trainen om toekomstige gezichtsuitdrukkingen bij mensen te anticiperen en deze tegelijkertijd met een persoon uit te voeren. De timing van deze gezichtsuitdrukkingen was van cruciaal belang. Vertraagde gezichtsnabootsing ziet er onoprecht uit, maar co-expressie van het gezicht voelt authentieker aan. Dit vereist dat de emotionele toestand van de mens correct wordt afgeleid voor een tijdige uitvoering.

Emo is een mensachtig hoofd met een gezicht dat is voorzien van 26 actuatoren die een breed scala aan genuanceerde gezichtsuitdrukkingen mogelijk maken. Het 'hoofd' is bedekt met een zachte siliconenhuid met een magnetisch bevestigingssysteem, waardoor eenvoudig maatwerk en snel onderhoud mogelijk is. Voor meer levensechte interacties integreerden de onderzoekers camera's met hoge resolutie in de pupil van elk oog. Hierdoor kan Emo oogcontact maken, cruciaal voor non-verbale communicatie.

Kunstmatige intelligentie

Het team ontwikkelde twee AI-modellen: een dat menselijke gezichtsuitdrukkingen voorspelt door subtiele veranderingen in het doelgezicht te analyseren, en een ander dat motorische commando's genereert met behulp van de bijbehorende gezichtsuitdrukkingen.

Om de robot te trainen in het maken van gezichtsuitdrukkingen, plaatsten de onderzoekers Emo voor de camera en lieten hem willekeurige bewegingen maken. Na een paar uur leerde de robot de relatie tussen gezichtsuitdrukkingen en de motorische commando's - ongeveer zoals mensen gezichtsuitdrukkingen oefenen door in de spiegel te kijken. Deze 'zelfmodellering' is vergelijkbaar met ons menselijke vermogen om ons voor te stellen hoe we eruit zien als we bepaalde uitdrukkingen maken.

Vervolgens maakte het team video's van menselijke gezichtsuitdrukkingen zodat Emo deze frame voor frame kon observeren. Na de training, die een paar uur duurde, kon Emo de gezichtsuitdrukkingen van mensen voorspellen. Hij kon kleine veranderingen in hun gezichten waarnemen terwijl ze de intentie begonnen te glimlachen.

Het vervolg

Traditioneel zijn robots niet ontworpen om rekening te houden met de uitdrukkingen van mensen tijdens interacties. Nu kan de robot menselijke gezichtsuitdrukkingen als feedback integreren. Wanneer een robot real-time co-expressies met mensen maakt, verbetert dit niet alleen de interactiekwaliteit. Het helpt ook bij het opbouwen van vertrouwen tussen mens en robot. In de toekomst zal de mens bij interactie met een robot dienst e gezichtsuitdrukkingen observeren en interpreteren, net als bij een echt persoon.

De onderzoekers werken nu aan het integreren van verbale communicatie, met behulp van een groot taalmodel zoals ChatGPT, in Emo. Nu robots zich steeds beter als mensen kunnen gedragen, moeten ontwikkelaars rekening houden met ethische overwegingen die met deze nieuwe technologie gepaard gaan.

Emo luidt mogelijk een overvloed aan positieve toepassingen in, variërend van huisassistenten tot educatieve hulpmiddelen. Het is de taak van ontwikkelaars en gebruikers om voorzichtigheid en ethische overwegingen te betrachten. De ontwikkeling van dit soort robots brengt ons dichter bij een toekomst waarin robots naadloos kunnen integreren in ons dagelijks leven en gezelschap, hulp en zelfs empathie kunnen bieden.

De wetenschappelijke publicatie vindt u hier.

Foto: John Abbott/Columbia Engineering